Se ha descubierto una debilidad de seguridad en el editor de código basado en inteligencia artificial (IA) Cursor eso podría provocar la ejecución de código cuando se abre un repositorio creado con fines malintencionados con el programa.

El problema se debe al hecho de que una configuración de seguridad lista para usar está deshabilitada de forma predeterminada, lo que permite a los atacantes ejecutar código arbitrario en las computadoras de los usuarios con sus privilegios.

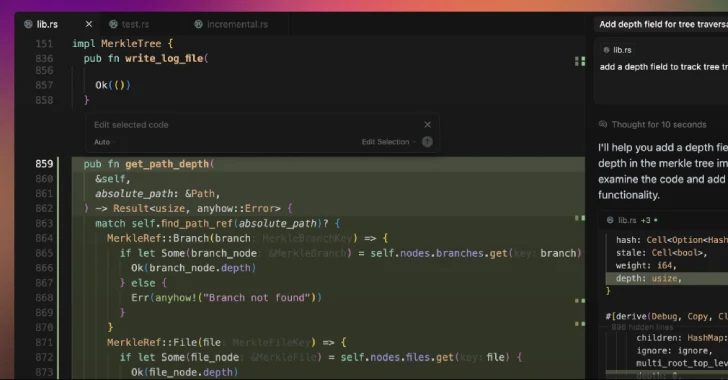

«El cursor viene con Workspace Trust deshabilitado de forma predeterminada, por lo que las tareas al estilo VS Code configuradas con RunOptions.runOn: 'FolderOpen' se ejecutan automáticamente en el momento en que un desarrollador explora un proyecto», Oasis Security dijo en un análisis. «Un archivo .vscode/tasks.json malintencionado convierte una 'carpeta abierta' casual en una ejecución silenciosa de código en el contexto del usuario».

Cursor es una bifurcación de Visual Studio Code impulsada por IA, que admite una función llamada Workspace Trust para permitir a los desarrolladores navegar y editar código de forma segura, independientemente de su procedencia o de quién lo haya escrito.

Con esta opción deshabilitada, un atacante puede poner a disposición un proyecto en GitHub (o en cualquier plataforma) e incluir una instrucción oculta de «ejecución automática» que indica al IDE que ejecute una tarea tan pronto como se abra una carpeta, lo que provoca la ejecución de código malintencionado cuando la víctima intenta navegar por el repositorio con trampas explosivas de Cursor.

«Esto tiene el potencial de filtrar credenciales confidenciales, modificar archivos o servir como vector para comprometer más ampliamente el sistema, lo que pone a los usuarios de Cursor en un riesgo significativo de sufrir ataques a la cadena de suministro», afirma Erez Schwartz, investigador de Oasis Security.

Para contrarrestar esta amenaza, se recomienda a los usuarios que habiliten Workplace Trust en Cursor, abran los repositorios que no sean de confianza en un editor de código diferente y los auditen antes de abrirlos en la herramienta.

El desarrollo se produce como inyecciones rápidas y fugas de la cárcel tener surgido como una amenaza sigilosa y sistémica que afecta a los agentes de codificación y razonamiento impulsados por la IA, como Claude Code, Cline , K2 Think , y Windsurf , lo que permite a los actores de amenazas incrustar instrucciones maliciosas en formas furtivas para engañar a los sistemas para que realicen acciones maliciosas o filtren datos de los entornos de desarrollo de software.

La empresa de seguridad de la cadena de suministro de software Checkmarx, en un informe publicado la semana pasada, reveló cómo Anthropic acaba de presentar revisiones de seguridad automatizadas in Claude Code podría exponer inadvertidamente los proyectos a riesgos de seguridad, incluida la posibilidad de indicarles que ignoraran el código vulnerable mediante inyecciones rápidas, lo que haría que los desarrolladores enviaran código malicioso o inseguro más allá de las revisiones de seguridad.

«En este caso, un comentario cuidadosamente escrito puede convencer a Claude de que incluso un código claramente peligroso es completamente seguro», dijeron desde la empresa dijo . «El resultado final: un desarrollador, ya sea malintencionado o simplemente intentando hacer callar a Claude, puede engañar fácilmente a Claude haciéndole creer que una vulnerabilidad es segura».

Otro problema es que el proceso de inspección de la IA también genera y ejecuta casos de prueba, lo que podría llevar a un escenario en el que se ejecute código malintencionado en bases de datos de producción si Claude Code no está correctamente aislado.

La empresa de IA, que también recientemente lanzado una nueva función de creación y edición de archivos en Claude, ha advertido que la función conlleva riesgos de inyección inmediata debido a que se ejecuta en un «entorno informático aislado con acceso limitado a Internet».

En concreto, es posible que una persona malintencionada añada instrucciones «discretamente» a través de archivos o sitios web externos (lo que se conoce como inyección indirecta de mensajes) para engañar al chatbot para que descargue y ejecute código que no sea de confianza o lea datos confidenciales de una fuente de conocimiento conectada mediante el Protocolo de contexto modelo ( MCP ).

«Esto significa que se puede engañar a Claude para que envíe información desde su contexto (por ejemplo, indicaciones, proyectos, datos a través de MCP, integraciones con Google) a terceros malintencionados», dijo Anthropic dijo . «Para mitigar estos riesgos, te recomendamos que vigiles a Claude mientras utilizas la función y que la detengas si ves que utiliza los datos o accede a ellos de forma inesperada».

Eso no es todo. A finales del mes pasado, la empresa también reveló que los modelos de IA que utilizan navegadores, como Claude para Chrome, pueden hacer frente a ataques de inyección inmediata, y que ha implementado varias defensas para hacer frente a la amenaza y reducir la tasa de éxito de los ataques del 23,6% al 11,2%.

«Actores malintencionados también están desarrollando constantemente nuevas formas de ataques por inyección rápida», dice adicional . «Al descubrir ejemplos reales de comportamiento inseguro y nuevos patrones de ataque que no están presentes en las pruebas controladas, enseñaremos a nuestros modelos a reconocer los ataques y a tener en cuenta los comportamientos relacionados, y nos aseguraremos de que los clasificadores de seguridad detecten cualquier cosa que el propio modelo pase por alto».

Al mismo tiempo, también se ha descubierto que estas herramientas son susceptibles a las vulnerabilidades de seguridad tradicionales, lo que amplía la superficie de ataque con un posible impacto en el mundo real -

- Una omisión de autenticación de WebSocket en Extensiones de Claude Code IDE ( CVE-2025-52882 , puntuación CVSS: 8,8) que podría haber permitido a un atacante conectarse al servidor WebSocket local no autenticado de la víctima simplemente incitándola a visitar un sitio web bajo su control, lo que permitía la ejecución remota de comandos

- Una vulnerabilidad de inyección de SQL en el Servidor Postgres MCP eso podría haber permitido a un atacante eludir la restricción de solo lectura y ejecutar sentencias SQL arbitrarias

- Una vulnerabilidad que atraviesa un camino en Microsoft NL Web que podría haber permitido a un atacante remoto leer archivos confidenciales, incluidas las configuraciones del sistema («/etc/passwd») y las credenciales en la nube (archivos.env), mediante una URL especialmente diseñada

- Una vulnerabilidad de autorización incorrecta en Adorable (CVE-2025-48757, puntuación CVSS: 9,3) que podría haber permitido a atacantes remotos no autenticados leer o escribir en tablas de bases de datos arbitrarias de sitios generados

- Vulnerabilidades de redireccionamiento abierto, secuencias de comandos entre sitios almacenadas (XSS) y filtración de datos confidenciales en Base 44 eso podría haber permitido a los atacantes acceder a las aplicaciones y al espacio de trabajo de desarrollo de la víctima, recopilar claves de API, inyectar lógica maliciosa en las aplicaciones generadas por los usuarios y extraer datos

- Una vulnerabilidad en Escritorio Ollama que surgen como resultado de controles cruzados incompletos que podrían haber permitido a un atacante realizar un ataque desde un vehículo, en el que visitar un sitio web malintencionado puede reconfigurar la configuración de la aplicación para interceptar los chats e incluso alterar las respuestas utilizando modelos envenenados

«A medida que se acelera el desarrollo impulsado por la IA, las amenazas más apremiantes no suelen ser los ataques exóticos de la IA, sino los fallos en los controles de seguridad clásicos», afirma Imperva. «Para proteger el creciente ecosistema de plataformas de 'codificación vibratoria', la seguridad debe considerarse como una base, no como una idea de último momento».

Post generado automaticamente, fuente oficial de la información: THEHACKERNEWS