OpenAI ha anunciado el lanzamiento de un «investigador de seguridad de agencias» que funciona con su modelo de lenguaje grande (LLM) GPT-5 y está programado para emular a un experto humano capaz de escanear, entender y parchear código.

Llamado Oso hormiguero , la empresa de inteligencia artificial (IA) dijo que el agente autónomo está diseñado para ayudar a los desarrolladores y a los equipos de seguridad a detectar y corregir las vulnerabilidades de seguridad a gran escala. Actualmente está disponible en versión beta privada.

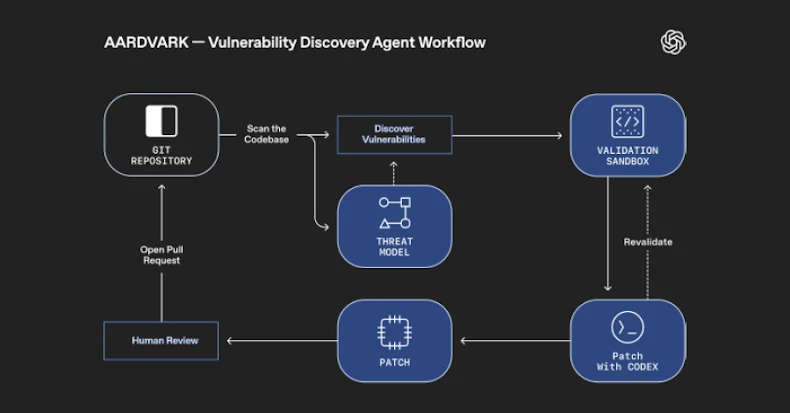

«Aardvark analiza continuamente los repositorios de código fuente para identificar vulnerabilidades, evaluar la explotabilidad, priorizar la gravedad y proponer parches específicos», OpenAI apuntado .

Funciona integrándose en el proceso de desarrollo de software, supervisando las confirmaciones y los cambios en las bases de código, detectando los problemas de seguridad y la forma en que podrían explotarse y proponiendo soluciones para abordarlos mediante el uso de herramientas y un razonamiento basados en la LLM.

Potenciar al agente es GPT-5 , que OpenAI presentó en agosto de 2025. La empresa lo describe como un «modelo inteligente y eficiente» que incluye capacidades de razonamiento más profundas, gracias al enfoque GPT-5, y un «router en tiempo real» para decidir el modelo correcto a utilizar en función del tipo de conversación, la complejidad y la intención del usuario.

Aardvark, añadió OpenAI, analiza la base de código de un proyecto para producir un modelo de amenazas que, en su opinión, representa mejor sus objetivos y diseño de seguridad. Con esta base contextual, el agente luego escanea su historial para identificar los problemas existentes, así como para detectar otros nuevos analizando los cambios entrantes en el repositorio.

Una vez que se encuentra un posible defecto de seguridad, intenta activarlo en un entorno aislado y aislado para confirmar su capacidad de explotación y aprovechar Codex OpenAI , su agente de codificación, para producir un parche que pueda ser revisado por un analista humano.

OpenAI dijo que ha estado ejecutando el agente en las bases de código internas de OpenAI y en algunos de sus socios alfa externos, y que ha ayudado a identificar al menos 10 CVE en proyectos de código abierto.

La empresa emergente de IA está lejos de ser la única empresa que prueba agentes de IA para abordar el descubrimiento y la aplicación de parches automatizados de vulnerabilidades. A principios de este mes, Google anunció CodeMender que, según dijo, detecta, parchea y reescribe el código vulnerable para evitar futuras vulnerabilidades. El gigante tecnológico también señaló que tiene la intención de trabajar con los responsables del mantenimiento de proyectos críticos de código abierto para integrar los parches generados por CodeMender y ayudar a mantener los proyectos seguros.

Desde ese punto de vista, Aardvark, CodeMender y ARCO se están posicionando como herramientas para el análisis continuo de código, la validación de exploits y la generación de parches. También se acerca poco después del lanzamiento por parte de OpenAI del modelos gpt-oss-safeguard que están ajustados para las tareas de clasificación de seguridad.

«Aardvark representa un nuevo modelo en el que los defensores dan prioridad: un investigador de seguridad agencial que se asocia con los equipos para ofrecer una protección continua a medida que el código evoluciona», afirma OpenAI. «Al detectar las vulnerabilidades de forma temprana, validar la capacidad de explotación en el mundo real y ofrecer soluciones claras, Aardvark puede reforzar la seguridad sin ralentizar la innovación. Creemos en ampliar el acceso a la experiencia en seguridad».

Post generado automaticamente, fuente oficial de la información: THEHACKERNEWS